在VR/AR发展的这数年中,关于苹果AR设备相关的报道属实不少,其中占据大头的除了爆料之外,最具可信度的当属专利。每次苹果有AR相关专利公布,就会被推上舞台的最中心——某种程度上这也代表着行业对苹果的好奇和期待。

这种好奇和期待,随着Apple Vision Pro的发布终于尘埃落定。有许多数码博主和科技媒体同行都抢先体验了它,并发出了“牛牛牛”的评价。与之相对的,也就产生了一种“都有实物了,谁还在乎专利”的微妙感受。

苹果的保密工作实在太好,我们除了“听”之外,看不到任何Vision Pro的实际体验画面和“言行”合一的硬件测评。不过,我们还是可以通过对专利的追溯,看看苹果Vision Pro到底有多“牛牛牛”。

经过几天的奋战,87君翻看了从2015至今大部分苹果有关VR/AR的专利,对Vision Pro来了一波“赛博拆机”,也帮助我们搞清楚了很多问题。

AR or VR,对苹果来说也是问题

首先就是苹果对Vision Pro这款产品的定位问题。

自从Vision Pro推出以来,VR或者AR又被推上了风口浪尖,重现2015-2016之态势(就像元宇宙一词刚出现的时候一样)。有人说它是VR,有人说它是AR,也有人说它是MR,众说纷纭、不尽相同。但无论是VR的纯虚拟环境、AR的虚拟叠加于真实之上,甚至更进一步虚实结合的MR,都不足以形容Vision Pro所带来的“在虚拟和现实中进进出出”的动态感。

实际上呢?苹果有没有对Vision Pro下过定义?还真有。

2020年1月,苹果CEO 蒂姆·库克获得了爱尔兰的嘉奖,奖励苹果连续40年在爱尔兰的投资。获得奖项时,库克表达了对未来5-10年科技发展的预期:“AR令我兴奋……我认为这是下一件大事,它会贯穿我们整个生活。”从此,苹果将AR这张牌摆在了明面上。

随后在2021年,苹果在专利中展示了其眼中的“下一件大事”。这份专利不仅包括苹果认为未来“AR”用什么样的操作系统、交互方法和硬件设备,也为其这一套系统下了新的定义——SR。

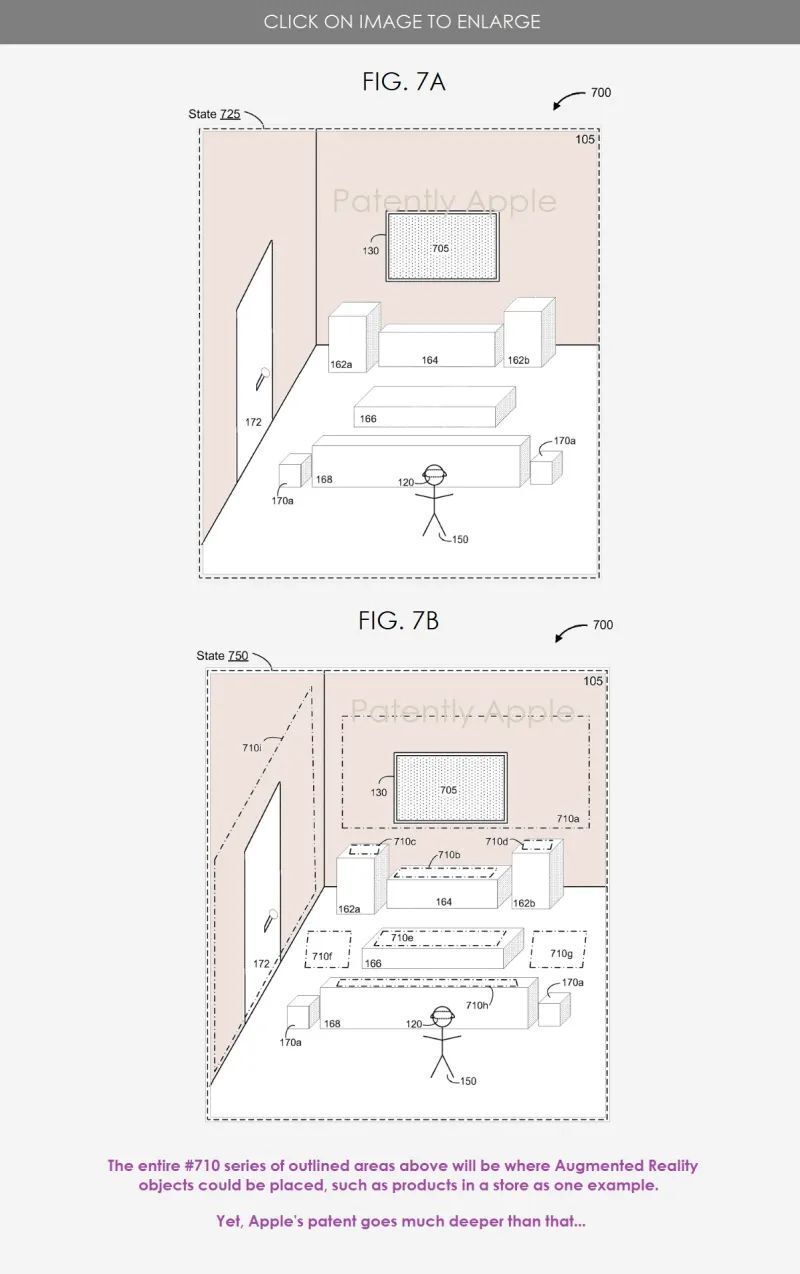

专利中说道,所谓SR即为Synthesized Reality,合成现实。大致的实现路径就是捕捉现实环境——在虚拟中还原环境——叠加虚拟内容——与用户实现交互/跟随用户的交互变化。

如果这很难理解的话,在专利中还进一步给出明确的解释,使用苹果这一系统,用户是通过物理环境的图像或视频“间接地”观看物理环境。

基于这样的显示效果或者系统逻辑,苹果设想了一些未来可能的娱乐场景。比如身临其境的观看一场拳击比赛,就好像整场比赛在你家客厅里举行一样。这与苹果在Vision Pro宣传视频中展示的内容已经非常接近,某种程度上,也算是苹果实现了自己的设想。

通过对专利的追溯和观察,我们发现一直以来苹果都没有把VR和AR看做两件事情分开做,而是致力于将二者合体。在上文的专利公开之前,苹果就有很多类似的技术布局,显著的证据有:

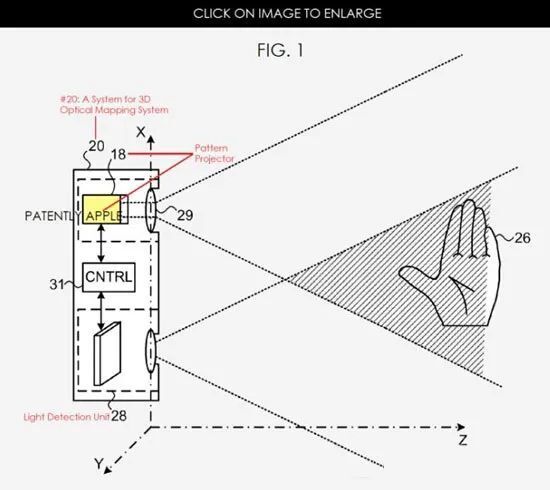

- 2016年,苹果有公布过关于3D光学测绘系统(3D optical mapping)的相关专利,大致可以理解为:设备发射出光线到物体表面——传感器收集物体表面反射的光线(三维数据)——处理器识别数据——处理器还原物体3D模型并加以利用。

这很可能是Vision Pro目前对虚拟+现实环境处理方式的最初来源。根据后续的专利显示,这一想法在苹果得到了相当深入的发展。

- 2017年一项由被苹果收购的Metaio转移到苹果名下的专利显示,苹果正在研究怎么通过移动AR系统监测周围的环境,并在VR环境下实时向用户显示信息。

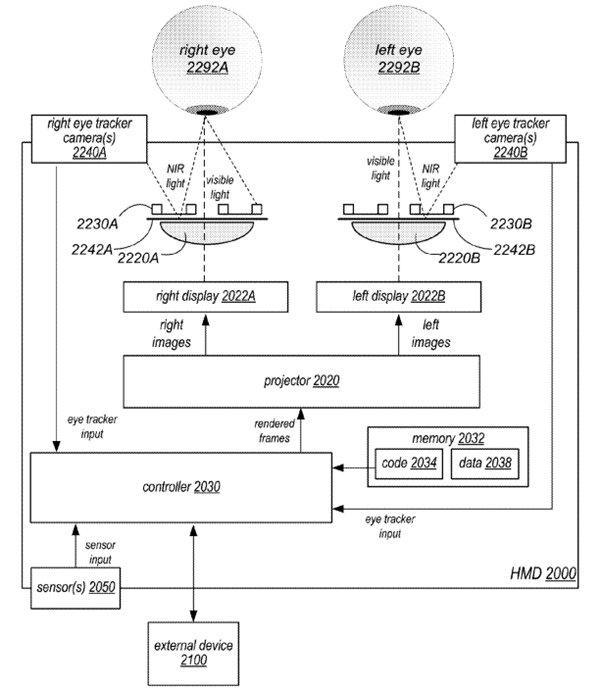

- 2019年初,苹果继续在“现实转VR叠加AR”这条路上深挖。专利曝光了有关苹果搭载眼动追踪的头显,其中提到,苹果可能利用视频处理引擎,重现并改良物理环境,比如利用虚拟物体增强原始场景,或补充真实物体的信息,将改良版场景传输到头显中,而这种视频过滤功能也会根据用户注视点改变而实时运行。

当时苹果并没有用类似Vision Pro的R1芯片来处理视频数据,而是利用外部基站处理数据再通过无线传输发送到头显端。

从以上这些专利中,不难看出苹果早早就设想未来的SR设备一定要具有当下流行的VST(Video See Through)功能,苹果Vision Pro利用它强大的12颗摄像头、单眼4K分辨率,最重要的是M1和R1两颗芯片提供的数据处理能力,在VST中间加入了畸变修正、颜色矫正等各种功能,让还原出来的场景真正能做到1:1。

看完这些,我们应该能明白Vision Pro的SR是什么,所用到的技术和VST都有哪些微妙的不同。那就再回到最初的问题,苹果对Vision Pro的定位是什么?

我们认为,苹果主要注意力还是集中在教育市场。做“最好的产品”是苹果一贯的风格,伟大的创新都搭建在已经出现的品类上。而基于VR/AR的普及程度、苹果提出的SR定义和对Vision Pro的构建方式,对苹果来说,Vision Pro就是一个全新品类,需要漫长的时间告诉用户这是什么,会带给用户什么样的体验。

简单的功能,可能需要8年打磨

从2016到2023,经过8年的时间,苹果初步完成了对其SR硬件的创作设计。但综合体验从不是“整体”说了算的,而是由各个部分带来的体验拼接的。在过往的专利中,我们也找到了苹果在体验上下的功夫。

比如大家关注的眼动追踪方面,苹果早在2017年公布的一项名为“Predictive,Foveated Virtual Reality System”的专利中就阐述了,为了提升硬件表现,可以采用注视点渲染功能进行优化,这里就势必会用到眼动追踪。其中,Predictive(预测性)这一点,也会是利用眼动追踪摄像头等传感器捕捉用户动作,以便判断图像哪部分需要以更高分辨率进行渲染。

也是同年,苹果收购了眼动追踪技术方面的翘楚SMI,并在次年公布了其HMD搭载眼动追踪技术的相关专利。

另外一项令人心动的功能,空间音频,也被加入到了Vision Pro中,这一点在专利中也早有体现。

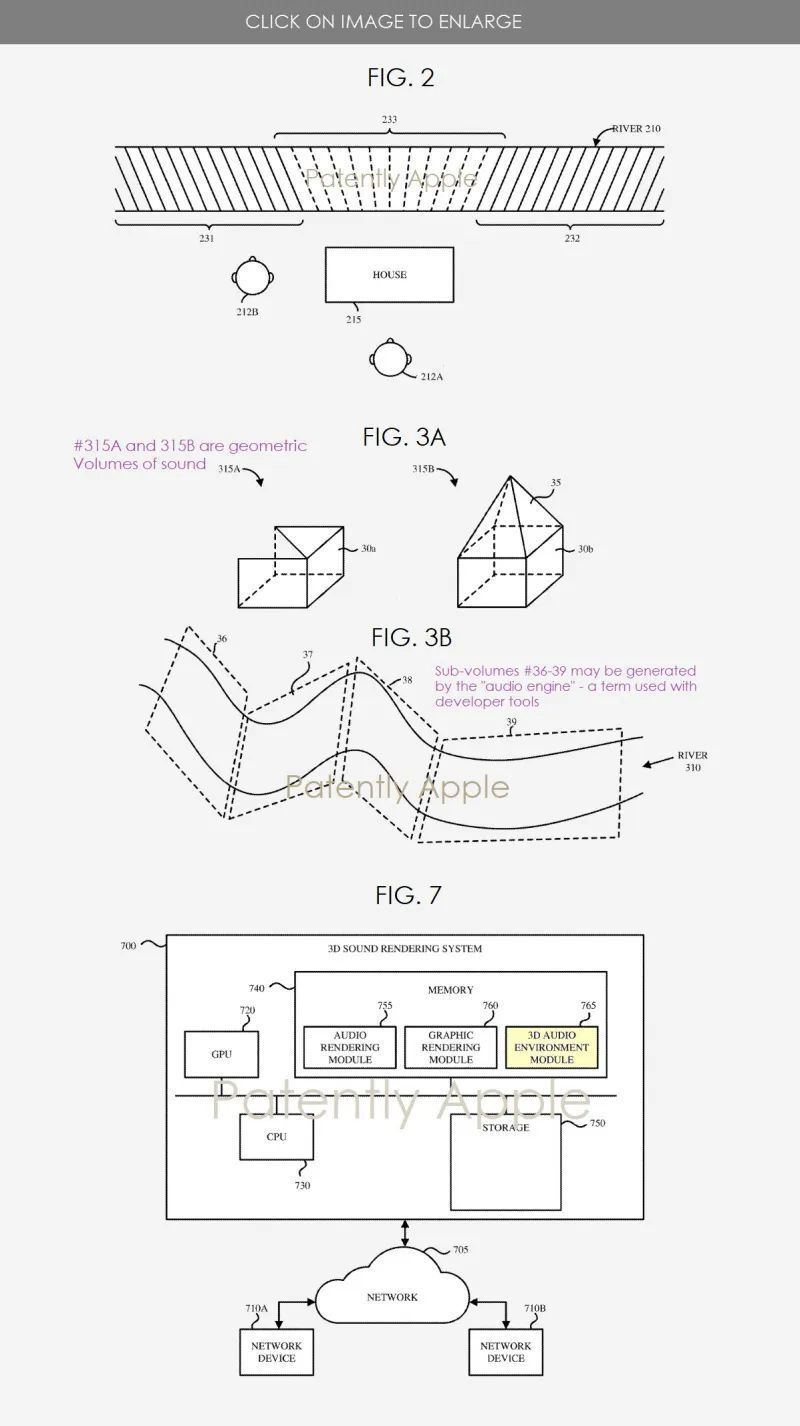

2020年,苹果陆续申请了多项有关空间音频的专利,其中就包括能够让玩家在虚拟游戏环境中更加沉浸的全新音频维度、为HMD申请的新“空间音频”专利等等。

比如通过还原3D场景以及场景中的物体,来尽量还原真实声音在真实环境中的感觉,提高声音的表现力和沉浸感。

也就是说真实的Vision Pro在沉浸感方面,绝不只是“根据你的位置改变声音传来的方向”那么简单,博主们分享的细腻听觉体验很可能也来自这项专利。

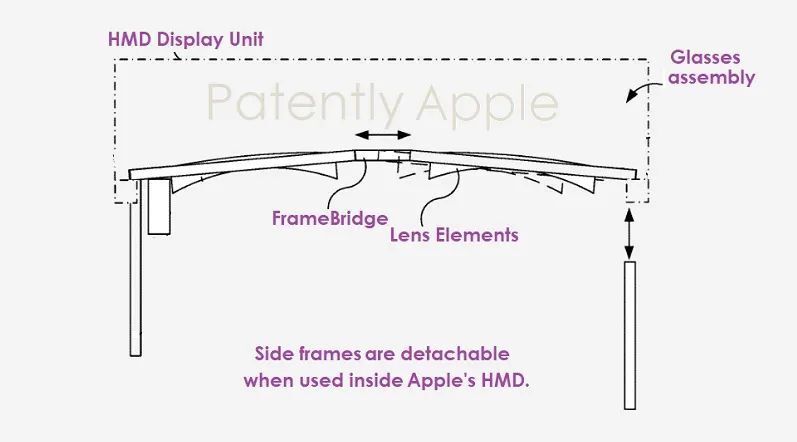

Vision Pro外观设计方面也有不少使用了专利。

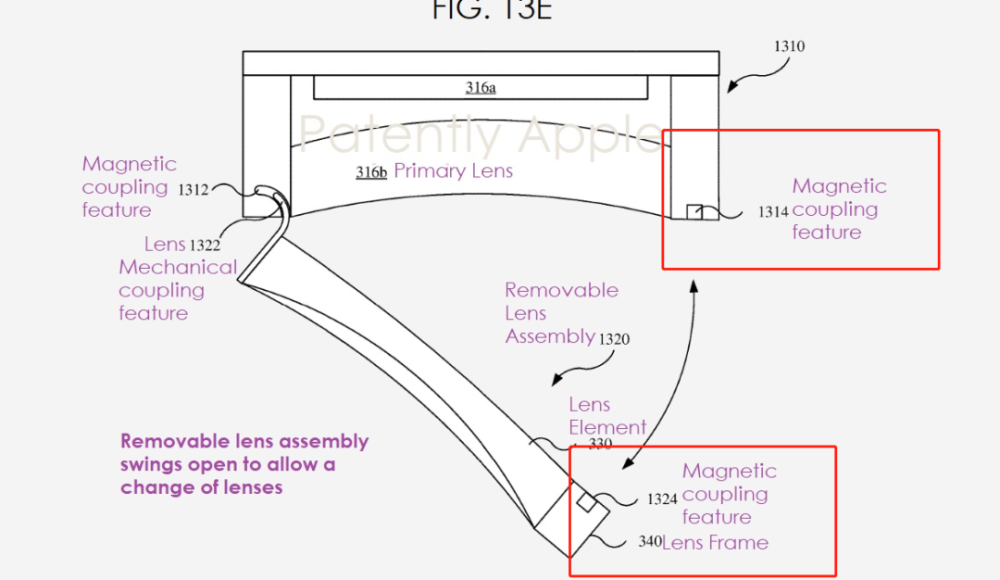

- 磁吸处方镜片。这项专利是苹果在2020年递交的,其中详细的描述了它的结构,磁吸连接且围绕显示元件。根据下面这张图片也不难看出,跟Vision Pro为磁吸镜片专门设置的凹槽已经非常接近。

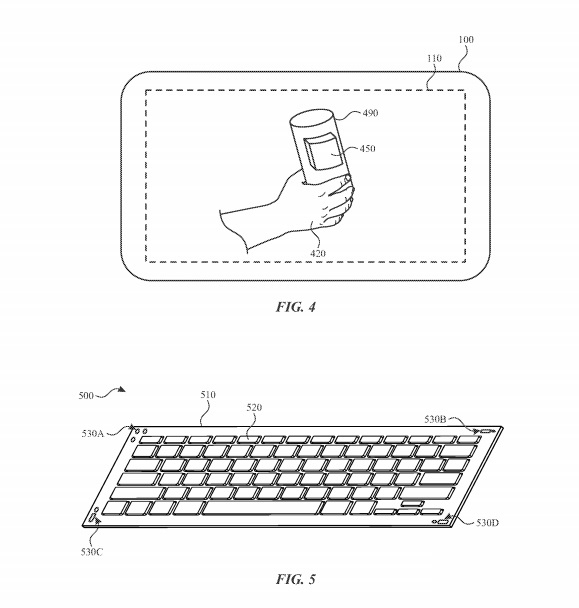

- 虚拟键盘。在Vision Pro宣传片中出现的虚拟键盘算是它非常有突破性的功能,关于这一功能的专利早在2020年就已经提交。根据专利描述,头戴式设备可以追踪用户手的位置来判断虚拟键盘的投射位置。

设备所具有的传感器可允许不依赖信号的情况下实现文本键入。换言之,头显可以根据用户对虚拟键盘的键入行为来解读文本输入,从而免除对实际物理键盘的需要。

- 头戴设计。Vision Pro的头带部分来源于2022年中旬获得的一项专利,其中包括后部头带和可拆卸头带两部分。

后部头带非常明显可以看到“可伸缩带”的字样,与现在Vision Pro的设计贴合。同时,虽然苹果没有具体展示,但也有媒体发现,Vision Pro可能会配有用来分配重量的顶部头带。苹果也对此回应,正在考虑要不要把顶部头带加入Vision Pro的包装中。

通过对专利的追溯,我们发现库克押注AR并不是一句空话,他们的的确确用了8年甚至更长的时间,考虑这款产品该怎么做。

苹果创新的集大成者——Vision Pro

相信看过专利的你,应该也能感受到,Vision Pro也不仅是一款新品,而是苹果过往技术的集大成者。

但Vision Pro能做到的应该远不止如上所说,苹果还有很多可以使用的技术“尚未确定”是否加入Vision Pro。

比如在AirTag中使用的UWB技术,很大可能会用来联动Vision Pro和Apple Pencil。在上文虚拟键盘的专利中,苹果提到可以支持Apple Pencil在虚空中挥动的输入,同时,2021年发布的专利中又显示HMD可以与“贴了定位追踪器的物体互动”。

这种感觉有点像,为你创造了一个和物理世界一模一样的虚拟世界,甚至每一个物体都可以帮你变成虚拟的。

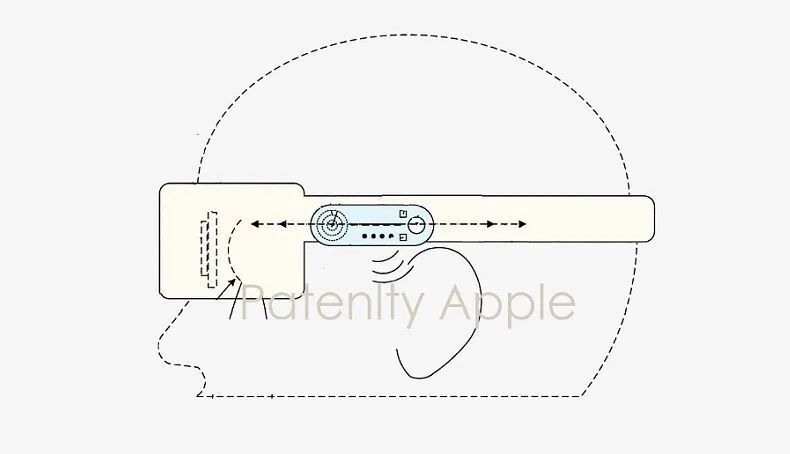

此外,我们还发现一个小细节,曾经公布的专利中显示,苹果在其HMD的侧面做了手动调节的音频模块,外形与Vision Pro几乎一模一样。不过在专利中,这一模块可以用来调整噪声消除的程度,但在Vision Pro中没有实装。

根据我们的猜测,都用上手势识别了,还需要用户通过滑动物理模块“有实感的”去调节音频,带来的体验显然不够匹配Vision Pro的科幻感。但调整降噪程度的功能足够实用,所以很可能在未来苹果调整交互后会实装。

看专利总是能发现一些此前没有关注到的问题,也在没有接触到Vision Pro的时候让我们更了解它一点。我们总是惊叹于苹果过去的辉煌,吐槽它iOS XX的升级毫无想象力,发表“苹果已死”的言论。但看专利时,仍旧会为这家公司近乎疯狂的想象力和执行力感到惊叹。

至于最后如何,我们只能拭目以待了——对了,这次是真的,很期待。