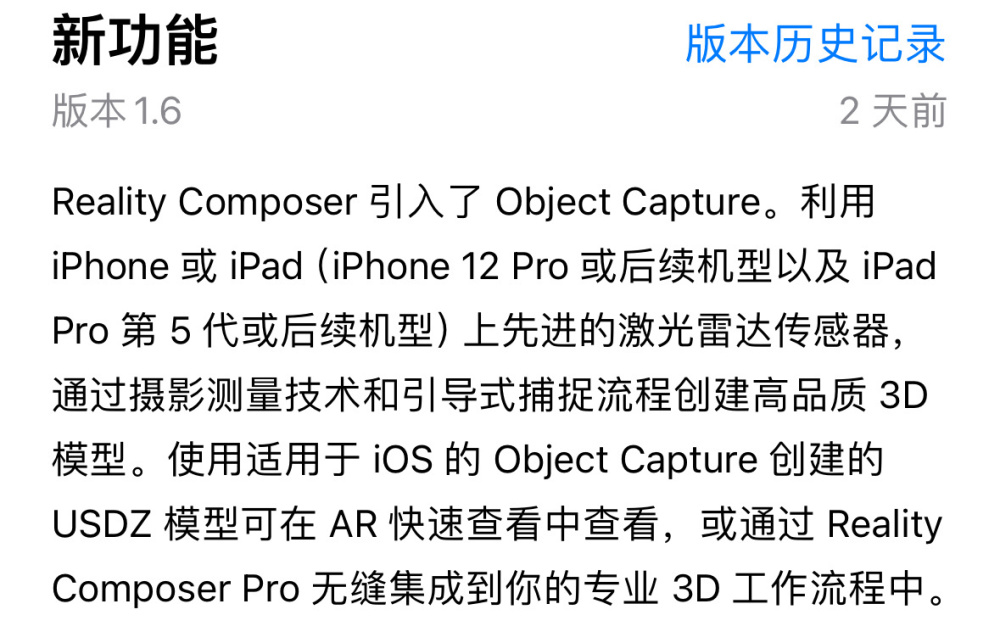

果粉迷 10 月 13 日消息,苹果公司日前为旗下 Reality Composer 应用添加了名为“Object Capture”的“3D 捕捉”建模功能,即利用配有 LiDAR 传感器的设备,扫描场景进行物件建模。

▲ 图源苹果 App Store

官方宣称,即使是未接触过 3D 的用户,也可“直接在 AR 环境中轻松制作 AR 原型并带来 AR 体验”,利用 iPhone 或 iPad(iPhone 12 Pro 或后续机型以及 iPad Pro 第 5 代或后续机型)上先进的 LiDAR 传感器,即可“通过摄影测量技术和引导式捕捉流程”创建“高品质 3D 模型”。

▲ 图源苹果 App Store

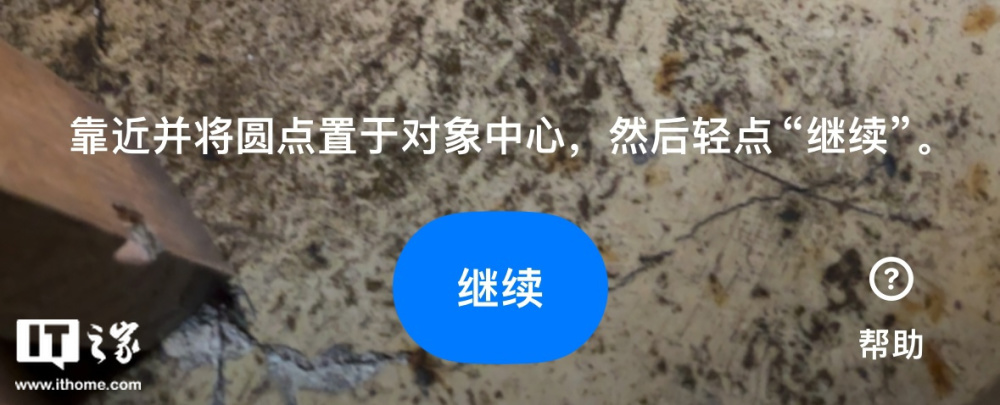

果粉迷利用一台搭载 LiDAR 传感器的 iPhone 14 Pro 进行测试,在点击“创建文稿”后,应用便会弹出“选择项目类型”页面,在此页面中,用户可以点击“Object Capture”进行模型创建(没有配备相关传感器的机型无此页面)。

进入创建页面后,应用要求用户将相关设备“靠近需要建模的物体”,此后用户需要手持相关设备,根据提示围绕物体围绕拍摄细节,在拍摄完成后,应用便会自动生成模型。

果粉迷创建了多个模型进行测试,相比市面上例如“3D Scanner App”等同类扫描建模应用,苹果 Reality Composer 创建的 3D 模型质量较高,但仅能扫描直径介于 200px 至 2m 之间的物体。

在创建模型后,用户还可以将模型以 USDZ 模式导出,并利用 AR 将相关模型放置于现实中进行观看。

苹果公司在今年推出了 Vision Pro 头显,其中一项特性便是允许用户将 USDZ 格式模式直接摆放在交互空间中,而当下 Reality Composer 推出了这一“拍照建模”功能,对于该头显的生态扩展及“趣味性提升”有一定的积极意义。